写在前面

今天阅读了一篇博客,里面分享了一个PPT让我突然对神经网络起了兴趣:https://www.yigegongjiang.com/2025/AI/。

其实之前毕设做的也是神经网络相关,只不过那时候太忙,到毕设结束都没真正搞懂注意力机制、反向传播和卷积CNN的底层原理,迷迷糊糊的就结束了。

话不多说,让我们开始正文的分享吧。

正文

引言

吸引我注意的就是这第一句话,我的思考是:人脑的智能都是由那些微小的细胞和神经元产生的,如果足够大的脑容量、足够多的神经元就能够自发孕育出智能,那用同样的办法我们也能通过足够多的人工神经元去模拟生物大脑中的神经元。真神奇!

但显然,无论是生物神经系统还是现代神经网络,都不是能简单理解的东西,所以我写下这篇博客用于记录我的学习.

神经网络结构图

顺带一提,我一直都觉得随着技术发展,ai的token数能变得越来越大到我们难以想象的数量级,那时的ai是否会成为真正的互联网万事通?也有可能在过程中迸发出更新的智能,从而做到自己更新自己,自己对自己进行迭代升级,再接着就是智械危机爆发?hhh好吧还早着呢

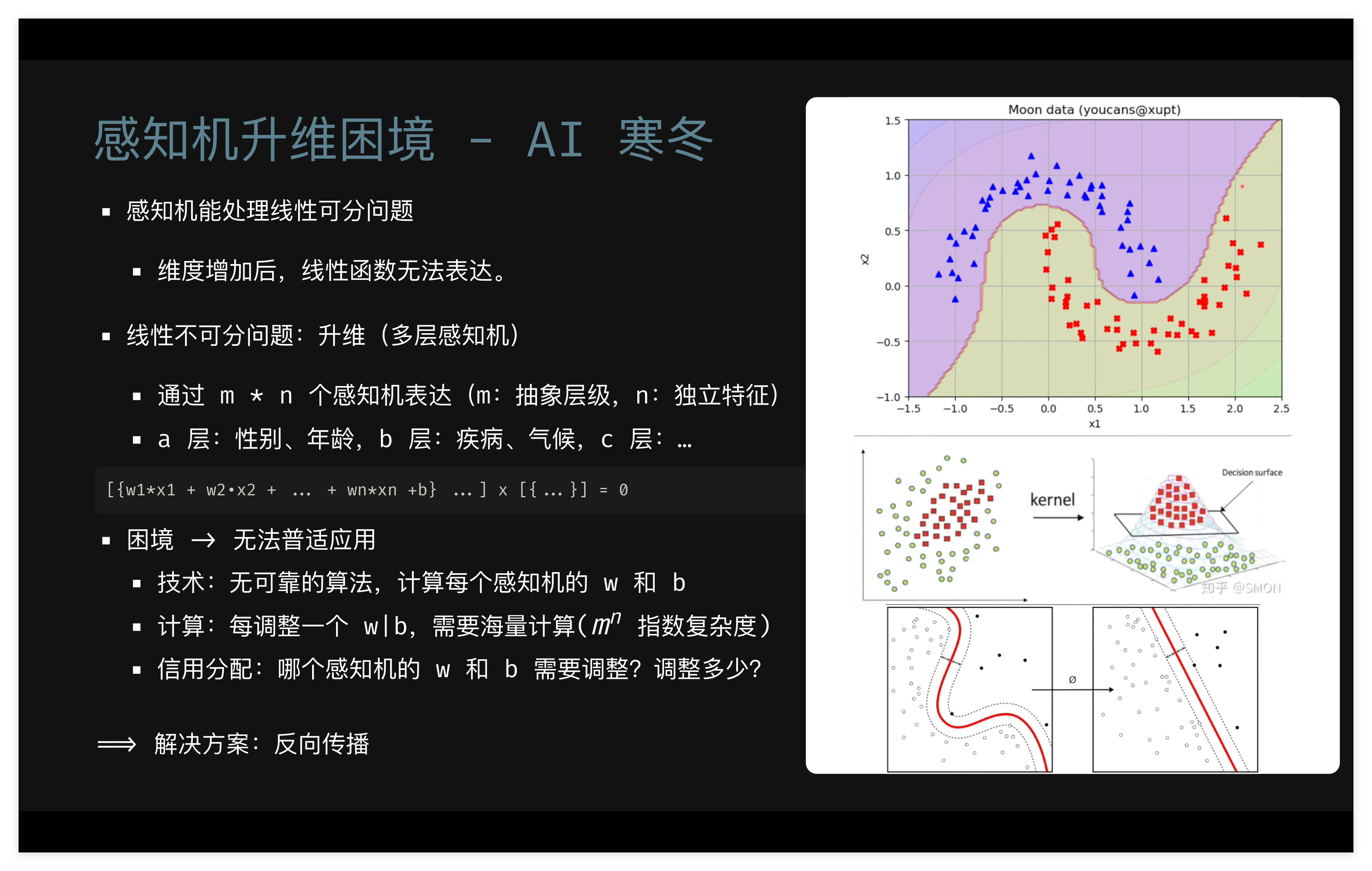

二元感知机难以升维

早期AI遭遇寒冬

反向传播的理论

正向传播是指数据从输入层流向输出层,反方向传播则是在训练的时候,通过计算

此处插入image4